Для обучения GPT-5 не хватит качественных данных из всего интернета

Разработчики передовых моделей искусственного интеллекта столкнулись с неожиданной проблемой — нехваткой качественного материала для их обучения. Ситуация усугубляется тем, что некоторые ресурсы блокируют доступ ИИ к своим данным. По словам исследователей, попытки обучать ИИ на материалах других моделей и прочем «синтетическом контенте» могут обернуться «большими проблемами».

Учёные и руководители компаний-разработчиков ИИ обеспокоены, что в ближайшие два года качественных текстов может не хватить для дальнейшего обучения больших языковых моделей (LLM), что замедлит развитие отрасли. Разрабатывающая ChatGPT компания OpenAI уже рассматривает возможность обучения GPT-5 на транскрипциях публичных роликов на YouTube.

Языковые модели ИИ собирают тексты из интернета — научные исследования, новости, статьи из «Википедии» — и разбивают их на отдельные слова или их части, используя их, чтобы научиться отвечать как человек. Чем больше входящих данных, тем лучше результат — именно на это уповала OpenAI, что помогло ей стать одним из лидеров отрасли. По словам изучающего искусственный интеллект в Исследовательском институте Epoch Пабло Вильялобоса (Pablo Villalobos), GPT-4 обучался на 12 триллионах токенов данных, а в соответствии с законами масштабирования Шиншиллы, ИИ вроде GPT-5 потребуется 60–100 триллионов токенов. Если собрать все высококачественные текстовые и графические данные в интернете, для обучения GPT-5 не хватит от 10 до 20 триллионов токенов, а может и больше — и пока непонятно, где их взять. Два года назад Вильялобос и другие исследователи уже предупреждали, что к середине 2024 года с вероятностью 50 % ИИ уже не будет хватать данных для обучения, к 2026 — с вероятностью 90 %.

По словам учёных, большинство данных в интернете непригодно для обучения ИИ, поскольку содержит бессвязный текст или не добавляет новой информации к уже имеющейся. Для этой цели подходит лишь малая часть материала — примерно десятая доля собранного некоммерческой организацией Common Crawl, чей веб-архив широко используется разработчиками ИИ. Тем временем, крупные платформы вроде социальных сетей и новостных агентств закрывают доступ к своим данным, а общественность не горит желанием открывать личную переписку для обучения языковых моделей. Марк Цукерберг (Mark Zuckerberg) считает огромным преимуществом в разработке ИИ доступ Meta✴ к данным на своих платформах, среди которых текст, изображения и видео — правда, трудно сказать, какую долю этих материалов можно считать качественной.

Стартап DatologyAI пытается бороться с нехваткой контента, используя методику «учебного плана», согласно которой данные «скармливаются» ИИ в определённом порядке, помогающем установить связь между ними. В опубликованной в 2022 году работе бывшего сотрудника Meta✴ Platform и Google DeepMind, а ныне основателя DatologyAI Ари Моркоса (Ari Morcos) подсчитано, что данный подход помогает добиваться сопоставимых успехов в обучении ИИ при сокращении входящих данных вдвое. Впрочем, другие исследования эти данные не подтвердили.

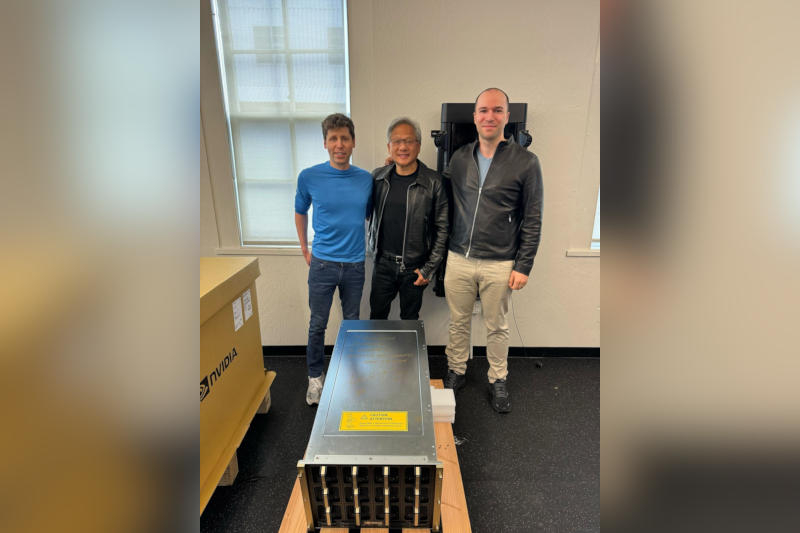

Сэм Альтман (Sam Altman) также рассказал, что OpenAI разрабатывает новые методики обучения ИИ. По слухам, в стенах компании обсуждается возможность создания рынка данных, на котором бы определялась ценность конкретных материалов для каждой модели и справедливая цена, которую можно за них заплатить. Эта же идея обсуждается в Google, однако конкретных подвижек в этом направлении пока нет, поэтому компании-разработчики ИИ стараются дотянутся до всего, что только можно, в том числе видео- и аудиоматериалов — по словам источников в OpenAI, их собираются расшифровывать инструментом распознавания речи Whisper.

Исследователи из OpenAI и Anthropic экспериментируют с так называемыми «высококачественными синтетическими данными». В недавнем интервью главный научный сотрудник Anthropic Джаред Каплан (Jared Kaplan) сказал, что подобные «сгенерированные внутри компании данные» могут быть полезные и использовались в последних версиях Claude. Пресс-секретарь OpenAI также подтвердил подобные разработки.

Многие исследователи проблемы нехватки данных не верят, что смогут с ней справиться, однако Вильялобос не теряет оптимизма, и верит, что впереди ещё много открытий. «Самая большая неопределённость в том, что мы не знаем, какие революционные открытия ещё предстоят», — сказал он.

По словам Ари Моркоса, «нехватка данных — одна из важнейших проблем отрасли». О днако её развитие тормозит не только это — необходимые для работы больших языковых моделей чипы также в дефиците, а лидеры отрасли обеспокоены нехваткой центров обработки данных и электроэнергии.

Источник